ML Basics – Die Transformer Architektur

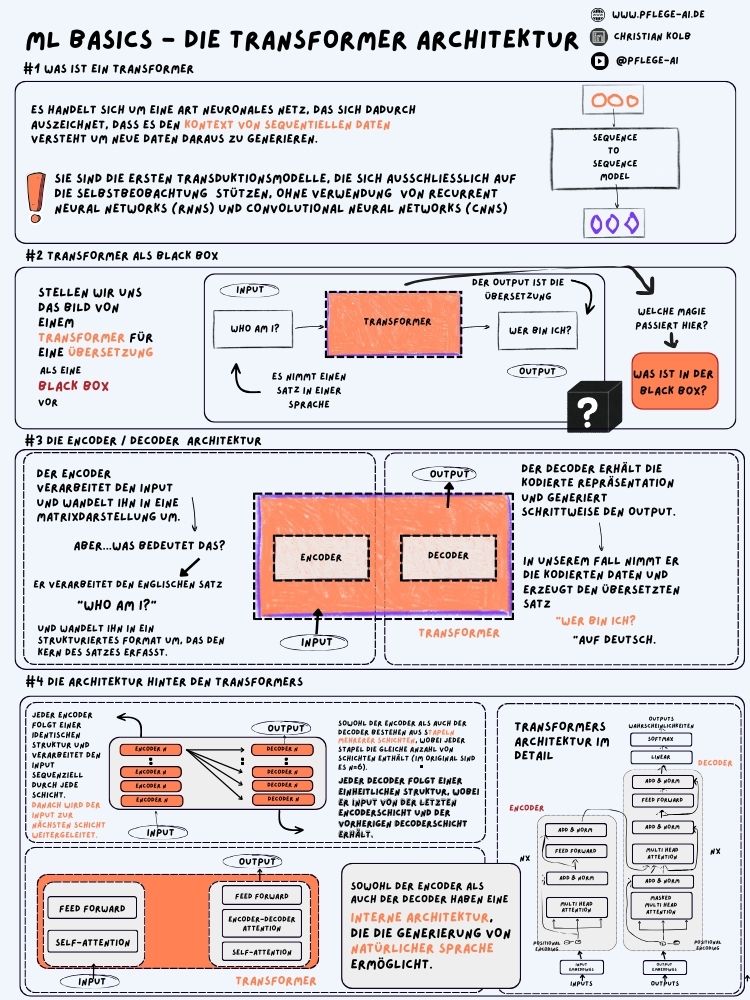

1. Was ist ein Transformer?

Ein Transformer ist ein neuronales Netz, das speziell dafür entwickelt wurde, um mit sequentiellen Daten wie Text umzugehen. Der Transformer hat eine besondere Fähigkeit: Er analysiert die Zusammenhänge in den Daten und kann dadurch aus bereits vorhandenen Informationen neue Erkenntnisse gewinnen. Dabei achtet er nicht nur auf die Reihenfolge der Daten, sondern auf deren Bedeutung im Kontext.

Ein wichtiger Punkt, der den Transformer einzigartig macht, ist, dass er keine rekurrenten (RNNs) oder konvolutionalen neuronalen Netzwerke (CNNs) nutzt. Stattdessen basiert er vollständig auf einem Mechanismus namens Selbstaufmerksamkeit oder „Self-Attention“, der es ihm ermöglicht, Muster in den Daten zu erkennen, ohne sich auf frühere Eingaben zu verlassen.

2. Der Transformer als Black Box

Stell dir vor, du möchtest einen Satz aus einer Sprache in eine andere übersetzen. Du gibst diesen Satz als Eingabe in ein System ein, das wie eine Black Box funktioniert. In dieser Black Box passiert die Magie des Transformators: Der Satz wird analysiert und in eine andere Sprache übersetzt.

Zum Beispiel nimmst du den Satz:

„Who am I?“

Der Transformer verarbeitet diesen Satz und liefert als Ausgabe:

„Wer bin ich?“

Was im Inneren dieser Black Box passiert, bleibt zunächst verborgen, aber die Transformerarchitektur sorgt dafür, dass die Bedeutung des Satzes erhalten bleibt, während er in eine neue Sprache übersetzt wird.

3. Die Encoder / Decoder Architektur

Ein Transformer besteht aus zwei Hauptkomponenten: dem Encoder und dem Decoder. Gemeinsam arbeiten diese beiden Teile daran, Eingabedaten zu verarbeiten und sie in eine verständliche Ausgabe zu verwandeln.

Der Encoder nimmt den Satz „Who am I?“ und wandelt ihn in eine strukturierte Form um, die der Transformer verstehen kann. Er zerlegt den Satz in einzelne Teile und analysiert sie.

Der Decoder erhält dann die vom Encoder verarbeiteten Daten und erstellt daraus den übersetzten Satz „Wer bin ich?“.

Durch diese Aufteilung in Encoder und Decoder wird der Transformer in die Lage versetzt, komplexe Aufgaben wie Sprachübersetzungen durchzuführen.

4. Die Architektur hinter den Transformers

Die innere Architektur des Transformators basiert auf mehreren Encodern und Decodern, die in Schichten aufgebaut sind. Jeder Encoder und Decoder ist dabei gleich aufgebaut und besteht aus mehreren wichtigen Schritten:

Encoder Schichten:

Self-Attention: Diese Schicht erlaubt es dem Transformer, die Beziehungen zwischen allen Wörtern in einem Satz zu verstehen. Das bedeutet, dass der Transformer nicht nur das aktuelle Wort analysiert, sondern auch, wie es im Verhältnis zu den anderen Wörtern im Satz steht. Diese Selbstaufmerksamkeit hilft dem Modell, den Kontext zu erfassen.

Feed Forward Layer: Nachdem die Selbstaufmerksamkeit analysiert hat, welche Wörter im Satz wichtig sind, verarbeitet diese Schicht die Informationen weiter. Sie sorgt dafür, dass das Modell die Daten noch detaillierter untersucht und den Satz in eine verständliche Struktur umwandelt.

Decoder Schichten:

Die Decoder-Schichten sind ähnlich aufgebaut, jedoch gibt es hier einen entscheidenden Unterschied: Neben der Self-Attention gibt es auch die Encoder-Decoder-Attention. Diese Schicht ermöglicht es dem Decoder, Informationen sowohl aus der Eingabe (dem Originalsatz) als auch aus der Verarbeitung im Encoder zu nutzen.

Auch hier folgt nach der Attention-Schicht eine Feed Forward Layer, die die verarbeiteten Informationen weiter strukturiert und den finalen Output (die übersetzte Sprache) generiert.

Interne Architektur:

Jede dieser Schichten wird mehrmals durchlaufen, sodass der Transformer jedes Mal ein tieferes Verständnis des Satzes erlangt. Es gibt keine Wiederholung in der Reihenfolge der Wörter wie in anderen neuronalen Netzwerken. Stattdessen konzentriert sich der Transformer auf die Bedeutung der Wörter im gesamten Satz.

Durch diesen mehrschichtigen Aufbau wird der Transformer extrem leistungsfähig und kann sehr schnell und präzise komplexe Aufgaben wie Sprachübersetzungen und Textgenerierungen durchführen.

Fazit

Die Transformerarchitektur hat die Art und Weise revolutioniert, wie neuronale Netzwerke mit Texten arbeiten. Dank der Self-Attention-Mechanismen und der Encoder/Decoder-Struktur kann der Transformer effizient mit sequentiellen Daten umgehen und dabei erstaunlich genaue Ergebnisse liefern. Besonders in Bereichen wie maschineller Übersetzung oder Textgenerierung zeigt der Transformer seine Stärken und bleibt bis heute ein zentraler Bestandteil moderner maschineller Lernverfahren.

Für eine detaillierte Erklärung der Transformatoren und ihrer Funktionsweise schaue auch hier nach: Was ist ein Transformer?

Warum ChatGPT nur ein Decoder-Modell ist

ChatGPT basiert auf der Transformer-Architektur, verwendet jedoch nur den Decoder-Teil des Modells. Um das besser zu verstehen, müssen wir uns die Aufgaben ansehen, die ein Encoder und ein Decoder im Transformer erfüllen:

- Der Encoder nimmt Eingaben wie Text oder Daten und verarbeitet sie, um ihre Struktur und Bedeutung zu verstehen. Er wandelt die Eingabedaten in eine Form um, die der Decoder später verwenden kann.

- Der Decoder nimmt diese verarbeiteten Daten und generiert daraus eine Ausgabe, beispielsweise eine Textantwort oder Übersetzung.

Da ChatGPT eine Textgenerierungsaufgabe übernimmt – es erstellt also eine Antwort auf eine Eingabe –, benötigt es keinen Encoder. Stattdessen verwendet es nur den Decoder, um auf die Eingabe zu reagieren.

Der Grund: Fokus auf Textgenerierung

Ein Decoder-Modell wie ChatGPT wird trainiert, um auf Grundlage von Eingaben wie Fragen oder Anweisungen verständliche und kohärente Texte zu erstellen. Es nutzt die Self-Attention-Schichten des Decoders, um den Kontext der bisherigen Unterhaltung zu analysieren und darauf basierend eine sinnvolle Antwort zu generieren.

Dabei muss ChatGPT keine komplizierte Verarbeitung wie eine Übersetzung durchführen (wo ein Encoder die Bedeutung eines Satzes erst entschlüsselt), sondern es antwortet direkt. Der Decoder kann daher die Eingabe „on the fly“ verarbeiten, da er schon mit Text arbeitet und keine zusätzliche Codierung von der Eingabe benötigt.

Zusammengefasst: ChatGPT ist ein reines Decoder-Modell, weil seine Hauptaufgabe darin besteht, Texte zu generieren – basierend auf dem bereits vorhandenen Kontext. Es verarbeitet die Informationen also direkt und wandelt sie in sinnvolle Ausgaben um, ohne einen Encoder zu benötigen, der die Daten zuerst aufbereitet.

0 Kommentare